01 멘토 소개

사내 해커톤 우수상!

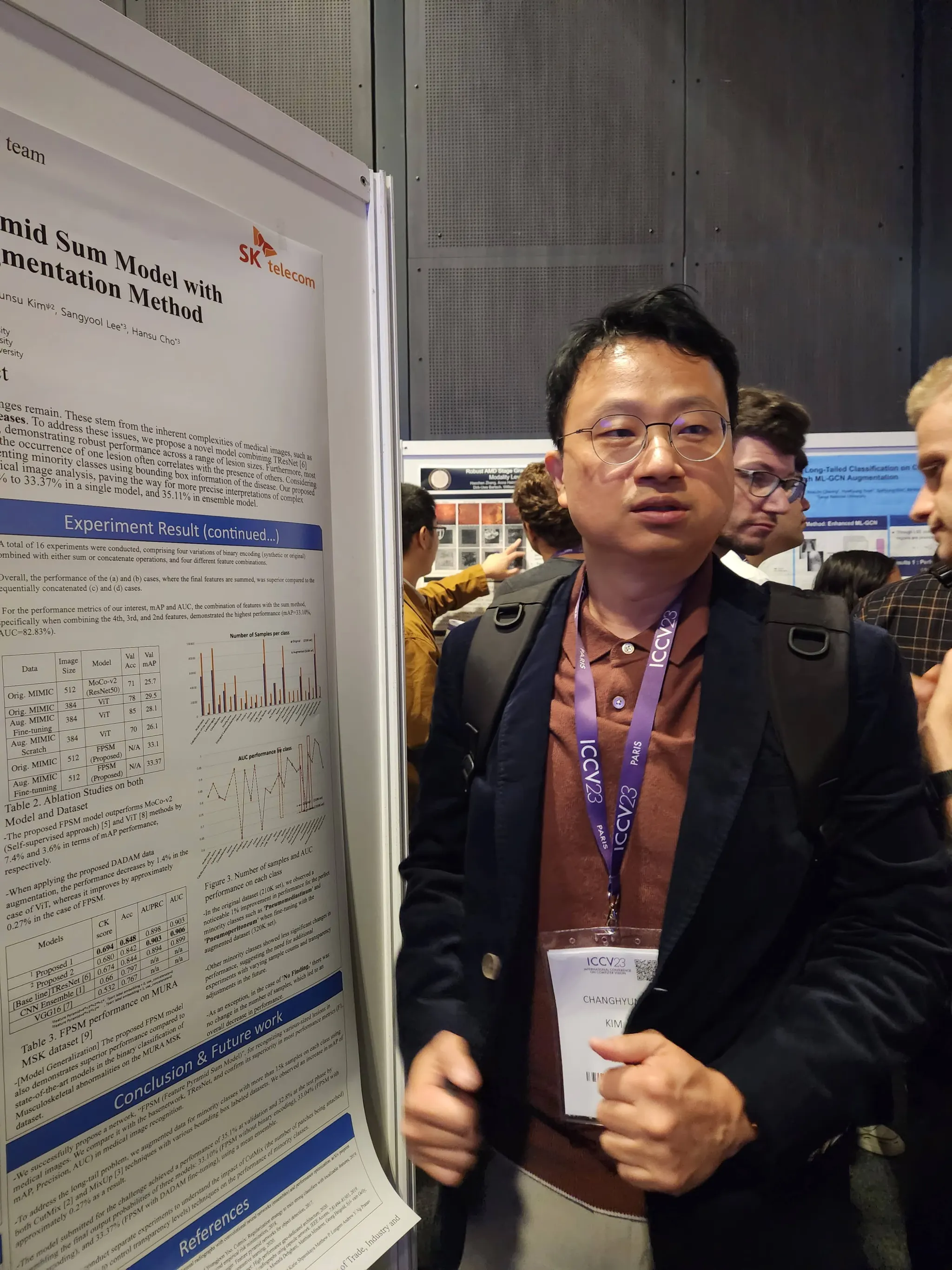

김창현

Bio & Brain Engineering Ph.D. / AI R&D

•

이전 직장 : 자율주행 보행자 인식 (GAN, Object Detection 등)

•

현직장 : Music AI, Emotion AI, 음성질환 Modeling, X-Ray (MSK, Chest, Veterinarian), AI Semiconductor (SAPEON@X-Caliber)

기타 (연구 성과/특허 경험 등)

•

2023 ICCV, AAO, iAIM, 2022 ICPR 워크샵, 2019 MIREX 등 논문 Accepted,

•

최근 10년간 국제 & 국내 AI 모델 특허 등록 및 출원 30여편

•

2023, 2021 SKT AI Fellowship 우수상 수상

이상율

Computer Science MS NLP 전공

•

차량용 임베디드 소프트웨어 개발업무로 회사생활 시작.

•

T map 기술개발팀에서 9년간 navigation service 개발 및 project managing 담당.

•

2021년부터 AI 관련 부서로 이동하여 다양한 업무 수행. 현재는 반려동물 X-Ray 진단 서비스인 X Caliber 의 AI 개발을 담당하는 BioMedical AI팀에서 PM 업무를 담당하고 있음.

기타 (연구 성과/특허 경험 등)

•

2023, 2021 SKT AI Fellowship 우수상 수상

◦

김창현 멘토와 함께 이번이 3번째 AI Fellowship 멘토링 프로그램 참여임.

•

SKT AI Challenge (사내 해커톤) 추천알고리즘 분야 최우수상 2022

02 프로젝트 소개

국내/외로 정신 건강이 갈수록 중요해지는 시대에 우리는 살고 있습니다. 개인의 정서적 심리 상태를 보다 잘 이해하는 것이 정신 건강을 유지하는 것에 필수 요소인 바,본 과제에서는 AI Hub 다양한 정신 건강 데이터 셋을 기반으로 Audio-Text-(생체신호) 기반의 감정 인식 연구를 진행하여 정신 건강 (Mental health - 스트레스, 감정, 우울)을 보다 잘 이해하고자 함에 있습니다. 현재 생체 신호는 Optional하게 선별하여 이번 Fellowship 에서 연구 과제로 진행 해보고자 합니다.

이전 AI Fellowship 을 통한 멀티 모덜 감정 연구 참조 : https://devocean.sk.com/blog/techBoardDetail.do?ID=163343

03 이런 Fellows를 찾아요!

지원시 다음의 사항을 고려하여 준비 하시면 가산점이 있습니다. 참고 부탁 드립니다.

•

Deep Learning 모델 관점 : Transformer, LLM 기반 멀티 모덜 정신 모델 (스트레스, 멀티 모덜 감정인식)

•

학습 기법 관점 : Self-supervised 방식의 학습 기법 사용 여부 (Pretrain/Finetunning 관점)

•

Explainable AI (Visualization) 기술을 이용한 감정 분류 해석 방안 여부

•

Dataset curation 방식 (다양한 AI Hub 데이터 셋 활용 방안 구체적으로 기술, 아래 참고)

•

[추가 가산점] 감정 인식 실 test app으로 개발 시 시나리오 소개

◦

데이터 셋

멀티모덜감정 데이터 - https://aihub.or.kr/aihubdata/data/view.do?currMenu=115&topMenu=100&dataSetSn=57

심리상담을 위한 멀티모달 데이터셋 - https://aihub.or.kr/aihubdata/data/view.do?dataSetSn=265

정신건강진단 및 예측을 위한 멀티모달 데이터 (안심존) - https://www.aihub.or.kr/aihubdata/data/view.do?currMenu=115&topMenu=100&aihubDataSe=realm&dataSetSn=573

참고 추가 데이터 셋

감정이 태깅된 자유 대화 (청소년) - https://aihub.or.kr/aihubdata/data/view.do?currMenu=115&topMenu=100&aihubDataSe=data&dataSetSn=71632

감성 및 발화 스타일 동시 고려 음성 합성 데이터 - https://aihub.or.kr/aihubdata/data/view.do?currMenu=115&topMenu=100&aihubDataSe=data&dataSetSn=71349

감성 및 발화 스타일별 음성 합성 데이터 - https://aihub.or.kr/aihubdata/data/view.do?currMenu=115&topMenu=100&aihubDataSe=data&dataSetSn=466

•

그리고 무엇보다 중요한 것은 협력 / 협업이 얼마나 잘 될 수 있을지 잘 표현 부탁 드립니다.

<2023 프랑스 파리 ICCV 논문 발표 시 - 김창현 매니져 (좌), 김보경 박사(노타), 이상율 매니져(우)>

FAQ

Q1 . 연구 목적에 음성과 언어 값을 사용하여 스트레스 혹은 감정 상태를 분류하고자 하는 것이 목적이라고 나와 있습니다. 그렇다면 대표 데이터셋에 포함되어 있는 비전 정보는 사용하지 않아도 괜찮은지 궁금합니다.

A1 . 네, 비젼 정보는 사용하지 않습니다. 다만 언급된 대로 생체 정보는 사용 하셔도 됩니다. 즉 음성 + 언어 + 생체 정보 혹은 음성 + 언어 정보가 사용 가능 합니다.

Q2-1. 개발하고자 하는 서비스의 음성 데이터가 복수 화자에 관한 데이터인지 단일 화자에 관한 데이터인지 궁금합니다.

A2-1 . 이번 AI Fellowship 멀티 모덜 감정 혹은 스트레스 인식 프로젝트 진행을 위해 위 공유 드린 AI Hub의 다양한 데이터 셋 링크에 들어가 보시면 대부분이 복수 화자에 대한 데이터 입니다. 이를 어떤 전략으로 데이터를 활용할 것인지 data curation 방법 (filtering, preprocessing, augmentation 등) , stagewise transfer learning 혹은 self-supervised learning 등을 얼마나 구체적으로 현실성있게 깊이 고민해봤는지를 평가 대상으로 합니다.

Q2-2. 생체 신호는 스마트폰 센서를 사용하여 수집된 데이터를 의미하는 것인지, 스마트워치와 같이 추가적인 기기를 통해 수집된 데이터를 의미하는건지 궁금합니다.

A2-2. 좋은 질문 입니다 . 위에 질문에 답변 드린 대로 생체 신호는 추가 할 수도 있으시고 음성 + text (한글) 만 가지고 실험을 설계 하셔도 됩니다.다만 인간의 감성 상태 (혹은 스트레스 정도)를 판단할 때 맥박, 혈압, 피부 전도도, 혈액 중 용존 산소량은 직접적으로 중요한 point 입니다.

이를 활용하여 감성 상태나 스트레스 정도를 문제 정의 하시는 것도 좋은 해결 방법을 제안하실 수 있을 거라 생각합니다. 스마트 워치로 부터 오는 생체정보는 꼭 딥러닝을 이용하지 않으셔도 된다는 말씀 입니다. 다만 상용화를 할 수 있을 정도로 충분히 고민하고 pilot study 결과도 내보시어 제안서를 작성하시기를 추천 드립니다.

. 위에 질문에 답변 드린 대로 생체 신호는 추가 할 수도 있으시고 음성 + text (한글) 만 가지고 실험을 설계 하셔도 됩니다.다만 인간의 감성 상태 (혹은 스트레스 정도)를 판단할 때 맥박, 혈압, 피부 전도도, 혈액 중 용존 산소량은 직접적으로 중요한 point 입니다.

이를 활용하여 감성 상태나 스트레스 정도를 문제 정의 하시는 것도 좋은 해결 방법을 제안하실 수 있을 거라 생각합니다. 스마트 워치로 부터 오는 생체정보는 꼭 딥러닝을 이용하지 않으셔도 된다는 말씀 입니다. 다만 상용화를 할 수 있을 정도로 충분히 고민하고 pilot study 결과도 내보시어 제안서를 작성하시기를 추천 드립니다.

Q3. 감정 분류 확률에 관한 질의입니다. 연구 목적이 화자가 말하는 각 발화에 대한 감정을 분류하는 것이 목표인지, 아니면 대화를 통한 화자들의 감정을 분류하는 것이 목표인 것인지 궁금합니다.

A3. 질문은 테스트 시나리오 (앱 으로 구성시) 와 관련이 있습니다. 만약 단일 화자의 질문에 대한 답변 구성으로 진행 시 "감정 인식 분류 문제"로 접근, 멀티 턴 (2명 대화)으로 AI agent와 질의 응답을 사용자가 할 경우의 "감정 자유 대화 생성 문제"로 접근이 그것입니다. 마지막으로 멀티 턴 (2명 대화) 일 때 실시간 통화 음성 감정 인식 문제로 주어진 AI Hub 데이터들을 통화 상태로 가정하고 사용 될 수도 있을 것입니다. 이렇게 세 가지 문제 정의 다 학습 데이터를 찾아보면 가능은 할 텐데 얼마나 성능이 나와 줄지 문제의 난이도와 확보 데이터가 관련이 있을것으로 판단 됩니다. 이에 문제 제약 조건을 드린 바와 같이 질문을 하신 지원자께서 모델 선택, 데이터 curation 등 pilot study를 충분히 진행 해 보시고 셋 중 본인 팀 (혹은 개인)에게 유리한 한가지를 선택을 하셔야 합니다. 현재 많은 지원자가 있는 관계로 성능이 더 좋을 것으로 판단되는 방법과 서비스로 구현 했을 때 사용자 편의성을 고려하시면 좋겠다는 첨언을 드립니다.

Q4. 과제에서 생체신호 값을 활용할 예정이라고 되어있는데, 이 때 프로젝트 페이지에서 제시한 AI hub 데이터에 대해서만 기술하면 될지, 연구 참여 시 사용할 수 있는 생체 신호 데이터 종류가 궁금합니다.

A4. 데이터는 public open 데이터 이면 모두 가능합니다.

Q5. 연구의 목적이 구체적으로 음성+텍스트에 대한 감정 분류 (7~8가지) 정확도 향상인지,음성+텍스트+생체신호 등을 통합적으로 활용하여 감정, 우울, 스트레스 등 전반적인 정신 건강을 판단하는 시스템의 도입인지 궁금합니다.

A5. 감정, 우울, 스트레스 중 제일 인식 성능이 잘 나올 것 같은 주제 하나에 대해 팀원들이 토론을 하시어 문제를 정의하고 가설을 세워 Deep Learning model 을 만들어서 풀어보는 것이 프로젝트의 목적 및 의의 입니다. 논문/특허/챌린지 중 하나를 시도할 것이며, 이를 달성 한 이후에 시간과 경비 등의 여력이 남는다면 서비스 앱 개발까지 시나리오 (제안서 가산점 부분)를 만들어 달성해보고자 합니다. *제출하는 논문, 특허, SW (모델, 서비스 앱 등)은 펠로우쉽 결과물로 SKT 자산 (특허권, 실시권 등)이 되며, 향후 논문 등재 시 협의와 논의 과정이 있음을 미리 말씀 드립니다.