01 멘토 소개

멘토 이름 김동현

A.DOT AI 데이터 - 데이터 플랫폼 - ML 최적화 팀

[개발 관련]

•

현 On Device AI 플랫폼 개발

◦

On Device AI 관련 디바이스 상 구동환경 플랫폼 개발

◦

On Device AI 관련 모델 최적화를 위한 EFFICIENT AI 기술 및 Mobile Aware LLMOPS 설계

◦

Application 액션 자동화 모델 환경 개발 (LAM + RAG)

◦

On Device (인지/판단/액션) 연계 파이프 라인 기술 개발

•

전) SKT (엣지 향) AI/ML 플랫폼 개발, 이동통신 시스템 가상화/엣지 설계,

삼성 : 서비스 플랫폼 개발, TMAX : JEUS 웹서비스 엔진 개발,

LG 이통연 : 3G RNC 네트워크 시스템 개발

[멘토링 관련]

•

국가 유공 인재 양성 정보통신부 장관상(2023), SW Maestro Mentor (2023, 5개 인증 팀 중 2개 수상 팀 멘토 - mLLM(whisper)/LLM 어플리케이션 주제)

표준 관련

•

현) AI Native 시스템, Cloud Native 시스템 표준화 위원,

전) 5G Edge MEC 표준화 위원

특허 관련

•

Edge Computing 관련, 모바일 서비스 플랫폼, 서비스 인프라 구조, Virtual Mobile Infra관련 등 (특허 10편).

02 프로젝트 소개

On Device상의 (인지/판단/실행) 모델 파이프라인 기술 개발

기술영역으로는 Generative AI (On Device LLM) 이며, 플랫폼 영역과 서비스 영역으로 기술 개발이 될 예정입니다.

함께 하는 과정중에 가이드 될 On Device LLM관련 기술의 습득과 멀티모달의 LLM 모델 연계에 대한 부분의 기술적 도전, 서비스에 대한 적용을 같이 할 수 있는 프로잭트 입니다.

1. PLATFORM 영역

(기존 기술 스택 학습, LLM연계 파이프 라인 및 Flexible RPA 기여)

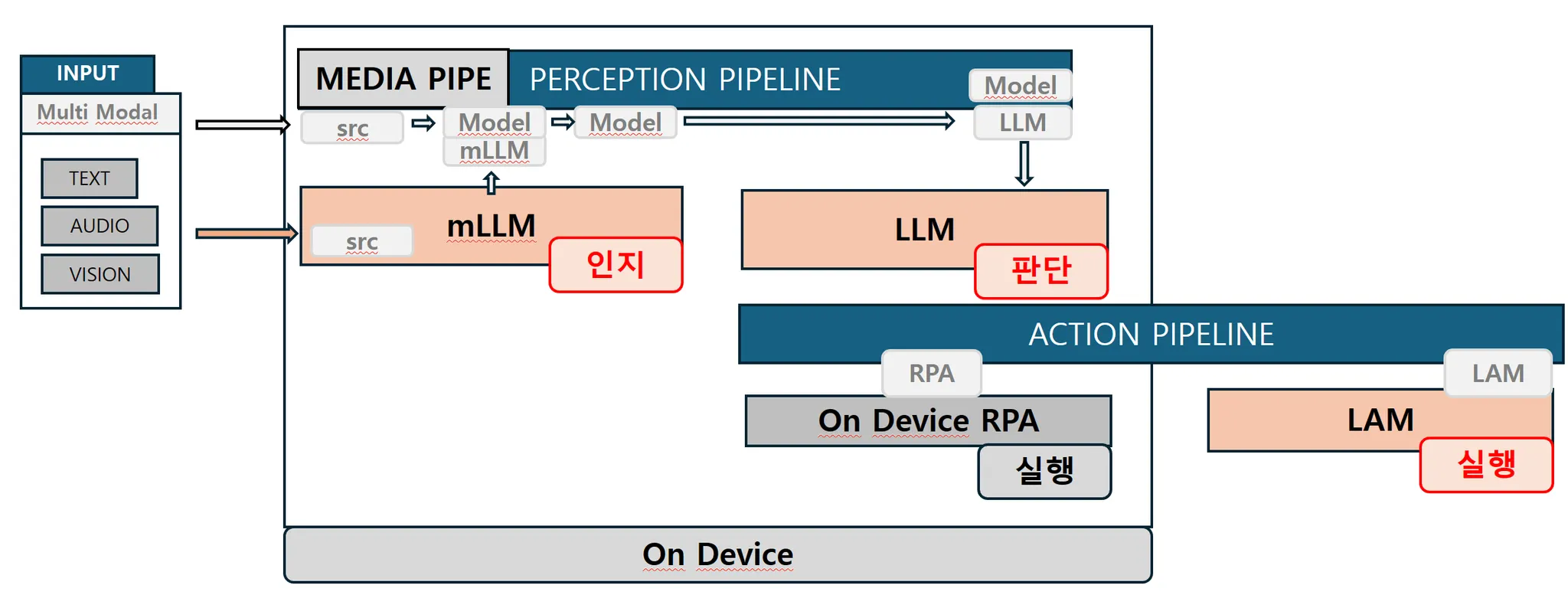

디바이스로 멀티 모달의 Input과 디바이스 내의 LLM 모델의 수행, Flexible RPA의 수행을 위한 파이프라인이 갖추어진 On Device AI 플랫폼

*mLLM : multimodal LLM, LLM (Large Language Model), LAM (Large Action Model), RPA (Robot Process Automation)

(인지 파이프 라인) 온 디바이스 상의 ML/LLM 활용 서비스 구성시 유저의 멀티모달 인풋에 대한 Task 단위의 처리 구성 및 재활용

(액션 파이프 라인) 사용자 측면에서 어플리케이션에 대한 인지/판단모델 이후의 실행을 구성함에 있어 유연함 제공하고 다양한 어플리케이션 연계

2. SERVICE 개발 영역 with PLATFORM

(플랫폼 기반으로 On Device AI 서비스 개발) - Any Thing Open (As You Wish)

현재 위의 플랫폼 형상을 기반으로 2개의 이상의 주제가 진행 되고 있으며, 플랫폼에 기여와 신선한 아이디어로 플랫폼 Enable 앱/서비스 도전 가능

** 주제의 범위가 있는 만큼 플랫폼 기여에 집중할지, 플랫폼 활용 서비스에 집중할지 시작시 정하고 진행할수 있습니다. 열정으로 2개 다 도전도 가능

** 플랫폼은 기존에 설계되고 진행되는 부분이 있어서, 지원자가 참여 하실 부분을 선택하고 기여가능 / 서비스는 주제를 정하고 플랫폼 기반으로 개발, 아이디어 구현을 위해 없는 모델이 있으면 개발하고 있는 모델은 활용하여 파이프 라인 적용하여 서비스 완성

(프로잭트 관련 기술 설명)

[ON DEVICE AI의 핵심 기술 On Device LLM]

( LLM은 "Large Language Model"의 약자이며, GPT를 생각하시면 될듯합니다. ) 이와 같은 LLM모델을 On Device는 장치(단말/핸드폰등) 내에서 작동하도록 하는 것이, On Device LLM이며, 장치 내에서 실행되는 (대규모) 언어 모델을 가리킵니다. 최근의 AI 폰과 같은 동작의 이면의 핵심이 되는 기술입니다.

[LLM의 인지/판단/액션을 위한 분화 mLLM, LLM, LAM, 그리고 On Device AI]

mLLM = LMM : (Large Multimodal Model) , LLM (Large Language Model) , LAM (Large Action Model)

LLM이 단말에 들어 온다는 것, 즉 (On Device LLM) 은 단말도 내부에 인지 및 판단을 가지게 되고, mLLM과 같은 멀티 모달로 부터 LLM의 연계를 통해 인지 / 판단에 대한 것을 처리 하게 됩니다.

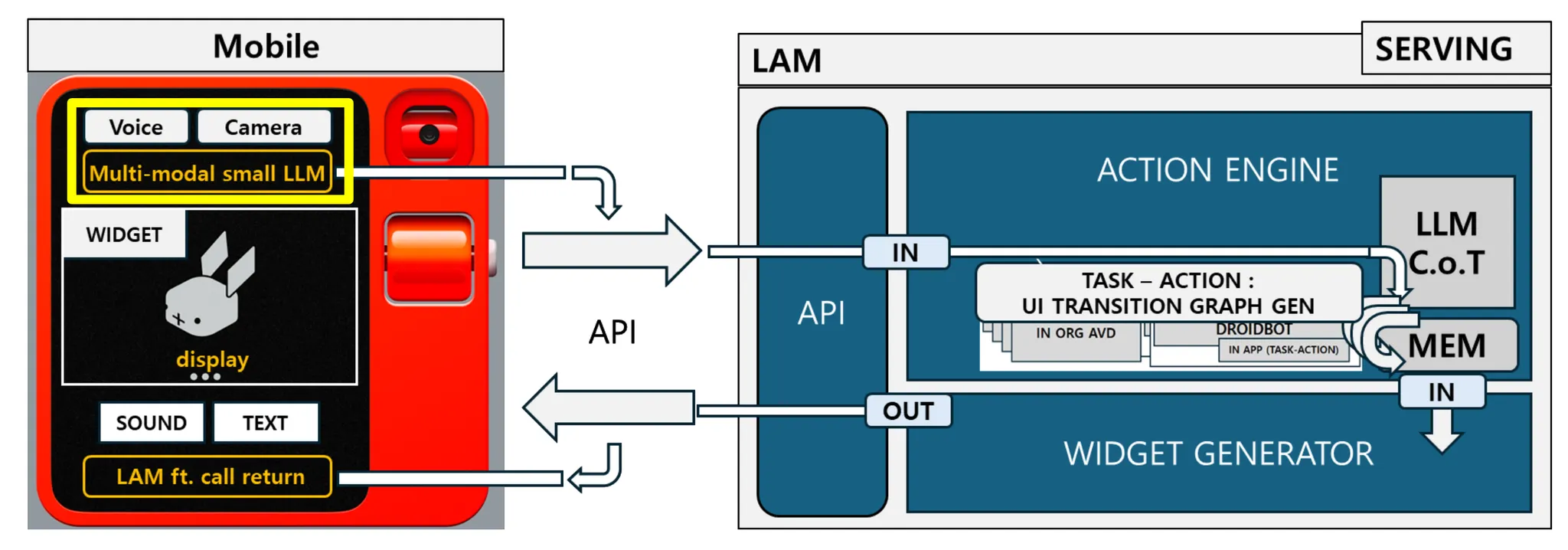

이 인지 판단의 결과를 실행과 연계 하기 위한 기술은 LAM (Large Action Model)의 부분이 필요하고 이를 실행 까지 연계 한다면, 단말 내부에서도 완벽한 On Device AI 가 갖추어 지게 됩니다.

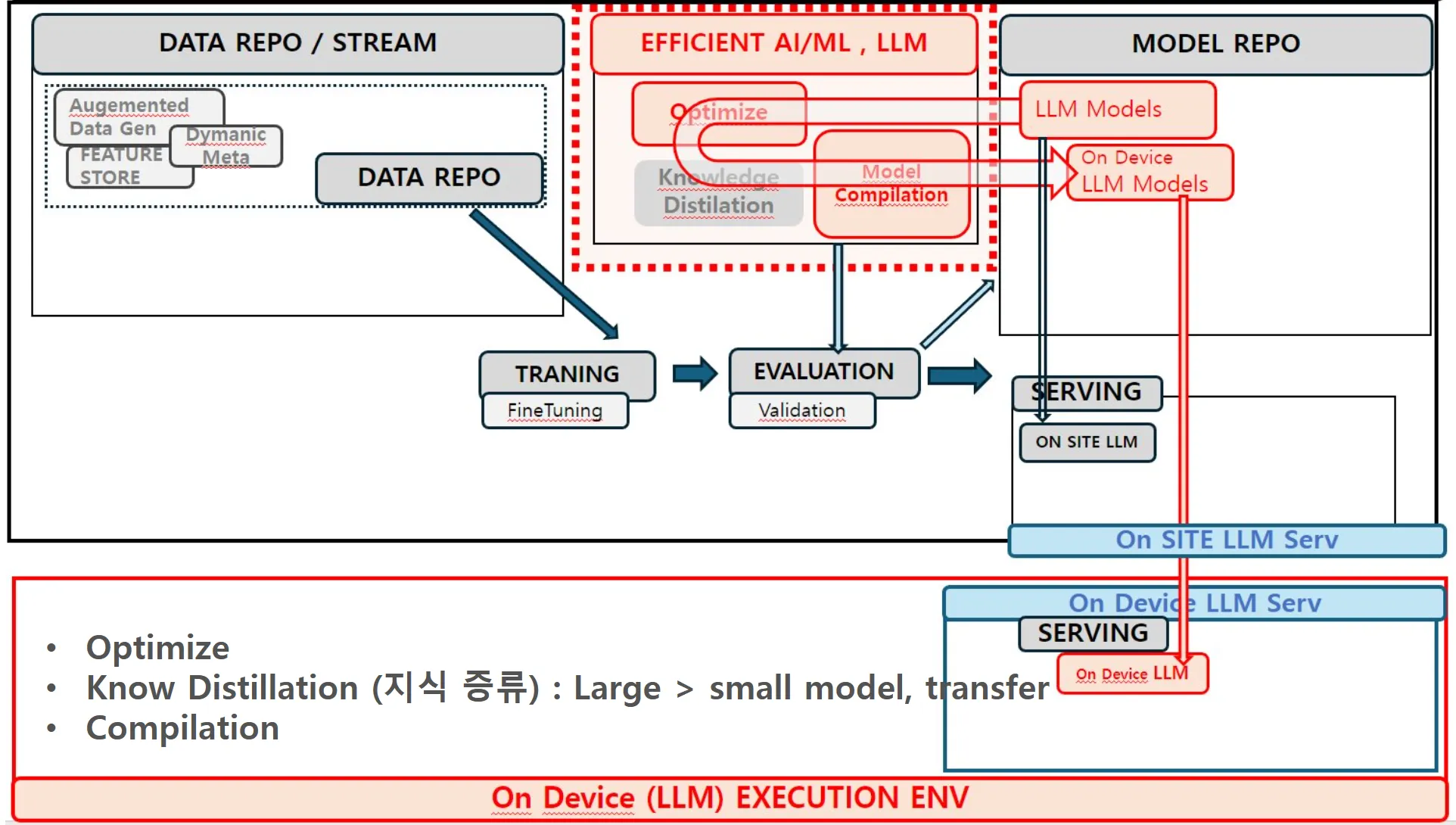

[기존 모델에서 On Device LLM이 만들어지는 기술 : EFFICIENT AI Tech]

하지만 단말 내부에 리소스의 한계에 의해 특정 능력별로 어플리케이션에 맞는 특화 경량화 모델이 적합하고, 이 때문에 특정 부분을 강화를 위한 특화 LLM 모델이 필요하고 이를 sLM이라고 합니다. 실제 On Device LLM은 On Device sLM이라고도 할수 있습니다.

이를 위한 모델 경량화 기술을 EFFICIENT AI라는 기술 도메인으로 연구되고 있습니다.

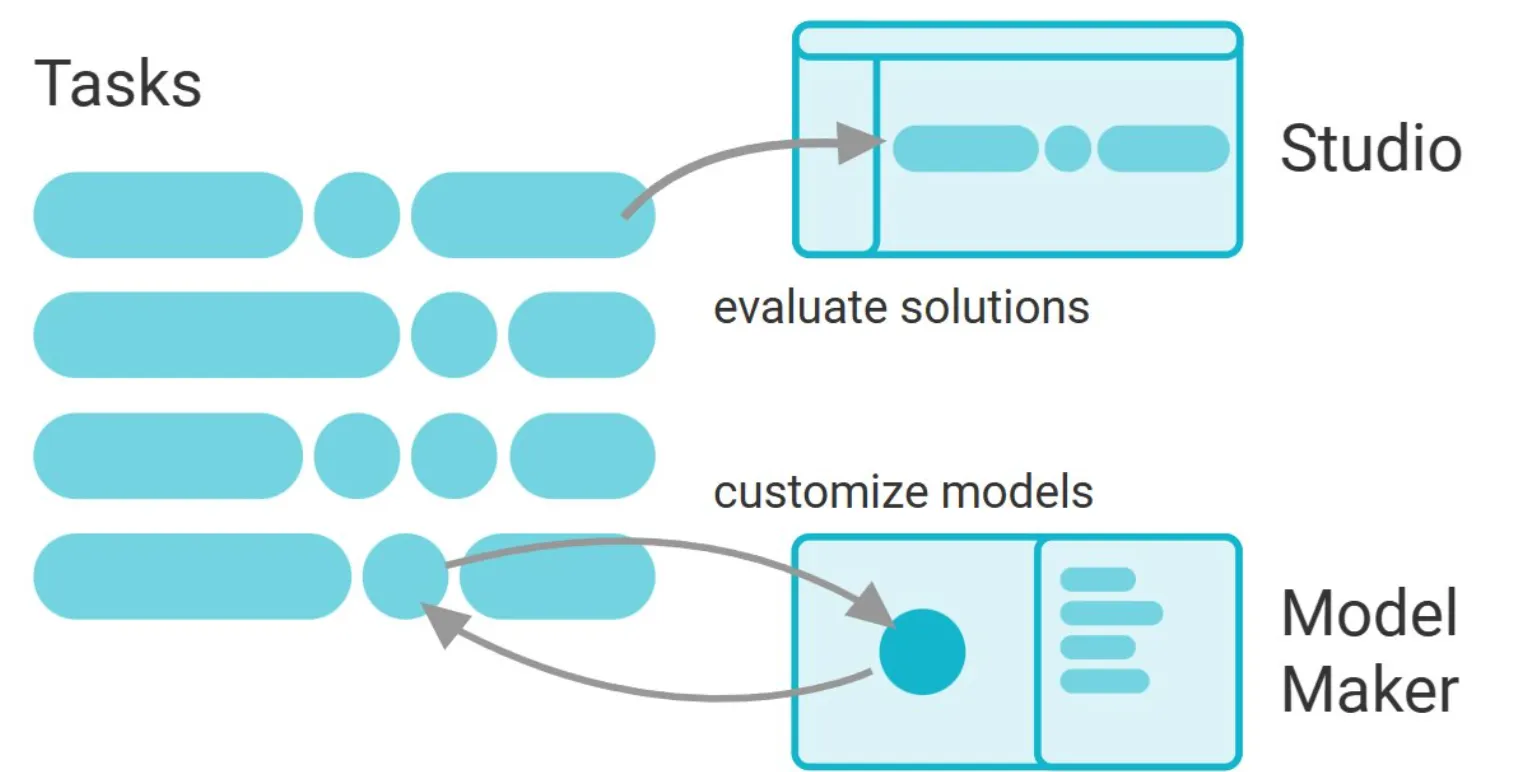

[서비스를 위한 모델, 작은 단위 기능 모델의 Orchestration 파이프라인]

이를 통해 가지고 서비스를 만든다면, 유저로 부터 입력 이후 인지 모델로 부터 판단 액션 과정을 조합을 해 다양한 서비스를 모듈화 하여 제공할 수 있고, 단말 내부에도 모델의 파이프라인으로 필요한 부분을 위한 조합을 만들 수 있습니다.

03. 기술의 활용점

최근의 발표 된 Rabbit R1 등 On Device PAA 디바이스는 이런 기술이 합쳐저서 유저의 서비스에 대한 질의에 대한 멑티모달 질의에 대한 처리 결과를 돌려 주게 됩니다.

이 이면에 위의 기술이 쓰여 지게 됩니다,

온디바이스 상의 AI 서비스는 small ML 모델 및 LLM의 사용으로 이루어 지며, 이때 인지 / 판단 / 액션 관점에서, 서비스 상황에 맞는 모델 및 연계는 다양하게 준비되고 연계 되어야 합니다.

04 발전하게 될 부분 / 기여하게 될 부분

참여하시게 되면, 지금 준비되고 있는 온디바이스 및 엣지 상의 LLM 구동 모델을 활용하여 모델 개발의 기술의 스택을 배우고 모델간 연계 부분의 개발 혹은 활용 서비스 개발에 있어 기여하고 small ML 모델에 대한 개발 및 서비스 향 파이프 라인 연계 사례 개발을 하게 됩니다.

1. 온디바이스 및 엣지 상의 mLLM, LLM, LAM 구동 모델 학습 및 기여

- (판단 모델) google GEMMA 등 LLM 엔진 사용한 단말 내에서 LLM 구동 모델을 기반으로,

- (인지 모델) mLLM (Multi Modal) LLM에 대해서는 LLAVA 및 GPT4-VISION 의 기술 등 활용

- (실행 모델) 단말상의 llm Assisted RPA 실행 모델 개발 기여 + 단말 외부의 UI 기반 실행 모델(LAM) 학습 모듈 활용

2. 모델 경량화 프로세스에 대한 경험 (Efficient AI 기술+LLMOPS)

On-device 상에서도 동작하는 작고 특정 작업을 잘하는 모델을 만들기 위해 기존 MLOPS과정에 더하여, Optimize, Knowledge Distilation, Mobile Target Compilation과정 (EFFICIENT AI) 을 거친 모델을 사용 및 필요하다면 실제 경량화 모델 제작 수행

* MLOPS/LLMOPS 과정 : 데이터 수집/정제, 학습, 평가, 서빙 과정 모델 LifeCycle 관리

3. google Mediapipe 오픈소스의 크로스 플랫폼 ML 및 LLM 파이프 라인 확장에 도전 기여

(ML 크로스 플랫폼 실행환경) ML에 실행환경에 있어 CROSS-PLATFORM (DESKTOP / ANDROID / IOS / WEB) 에 대한 크로스 플랫폼 환경과 이를 통한 모델의 경량화 수준에 따라 배포 실행 모델을 연동시키는 것을 배우게 되십니다.

ML 기반의 CROSS-PLATFORM의 기술을 Google MediaPipe 오픈 소스로 수행하고 확인하고, LLM에 대한 확장, Realtime Sound Processing등의 Media 처리등의 모델의 LLM연계를 수행하며, 본 과제를 수행하면서 이에 대한 오픈 소스의 특정 피쳐는 여러분이 기여를 할 수 있게 됩니다.

(인지 파이프 라인 개발 기여) 온 디바이스 상의 ML/LLM 활용 서비스 구성시 유저의 멀티모달 인풋에 대한 Task 단위의 처리 구성 및 재활용하기 위한 파이프라인 레이어에 대해 활용하고 LLM 연계 Feature 개발

(액션 파이프 라인 개발 기여) 사용자 측면에서 어플리케이션에 대한 인지/판단모델 이후의 실행을 구성함에 있어 유연함 제공하고 다양한 어플리케이션 연계 하는 기능인 액션 파이프라인에 대해 Flexible RPA 확장에 기여

4. On Device AI 기술 기반의 PAA 서비스 플랫폼 및 서비스 개발 경험

•

PAA (Personal AI Agent) 향의 On Device 서비스 플랫폼을 배우고 기여하고, 서비스에 적용

5. 관련 작업에 대한 특허 / 논문 작성 및 표준에 대한 기여 도전

* 멘토 현 Edge Cloud, AI/ML 관련 표준 위원, Edge Cloud관련 특허 10편 의 경험으로 과정을 도와 드릴 수 있습니다.

05 이런 Fellows를 찾아요!

생성형 AI 연구, 모델 최적화, 서비스 플랫폼에 경험/관심이 있고, On Device AI 연구 개발 경험 및 높은 관심/열정이 있으신 분.

Android / iOS (크로스 플랫폼) 에 사용할수 있는 인지 ML 프래임워크 기반으로, LLM 연계 기술을 깊이 알고 싶으신분.

유망한 오픈 소스 프로잭트를 실제 깊게 들여다 보고 도전하고 기여를 하고 싶으신 분 이 기여 부분에 대한 UC 개발 까지 하고 싶으신 분.

FAQ

Q1. LLM model의 distribution을 보고, 해당 분포에 최적화된 quantization 기법을 도입하는 것을 생각하고 있습니다. 해당 key 논문으로 'smoothquant'나 'AWQ"와 같은 논문들이 대표적인데, 이러한 하드웨어 친화적인 quantization 기법만 아이디어로 구상해서 제출해도 되는 것일까요?

A1. 해당 과제는 모바일 디바이스 타겟으로, 최적화 된 모델에 대한 부분이 조금은 우선시 되어 있는 부분이 있으나, 주제의 진행은 완성도 있는 연구 제안이면 선정이후, 참여 팀의 의견을 반영하여 진행 방향을 수정할 수 있습니다.

Q2. quantization을 생각하고 있는데, 이후 과정도 상세히 연구 아이디어 제안을 드려야 하는 것인지 알려주시면 감사드리겠습니다.

A2. 연구 자체 대한 완성도 있는 제안 이 가장 중요 하겠지만, 상세 연구 아이디어에 대한 부분이 활용 관점에서 연계 점이 있다면 더 좋을 듯 합니다. 경량화 모델이 모든 분야가 아닌 특정 분야에 대한 전문화 된 모델을 위해 모듈처럼 쓰이는 부분이 있어 활용 분야에 대한 아이디어도 같이 있으면, 모델 만드는 목적이 뚜렷해 지고 최종 완성된 프로젝트의 어필에도 좋을 듯 합니다.